Computer an Auge - Ich sehe was, was du nicht siehst: Bildanalyse mit Künstlicher Intelligenz

Mario Rembold, Laborjournal 10/2021

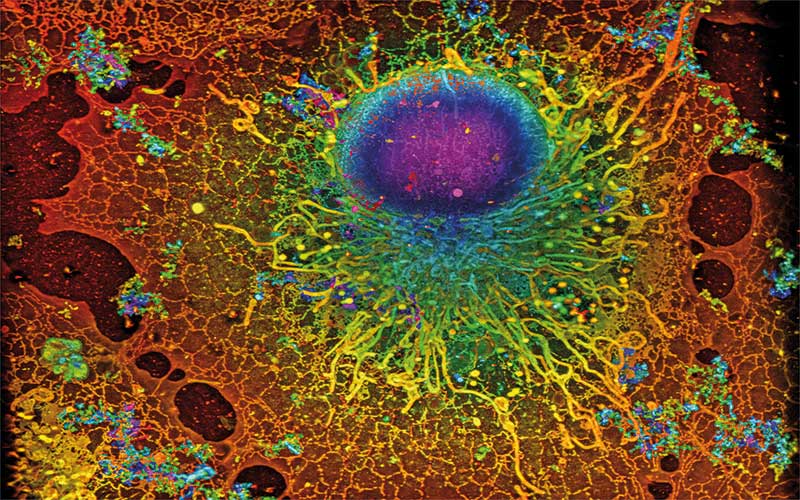

(12.10.2021) Es gab Zeiten, in denen Forscher monatelang durch das Mikroskop starrten, um Zellen zu zählen oder deren Entwicklung zu verfolgen. Heute kann der Computer dem Menschen einen Großteil dieser Arbeit abnehmen. Viele moderne Mikroskopieverfahren kommen ohnehin nicht mehr ohne die Datenauswertung am Rechner aus.

„Ich glaube, die generelle Herausforderung sind die Datenmengen, die durch moderne Mikroskope zusammenkommen“, meint Anna Kreshuk, Leiterin der Arbeitsgruppe Machine Learning for Bioimage Analysis am EMBL in Heidelberg. „An einem Lichtscheibenmikroskop können das Terabytes werden“, nennt sie ein Beispiel. Kreshuks Team widmet sich dem Segmentieren von Bilddaten. Mit Segmentierung ist gemeint, dass aus den Pixeln letztendlich einzelne Objekte im Bild werden. Als Analogie: Wenn wir in der Stadt zwischen Häuserzeilen entlanglaufen, entstehen aus dem zweidimensionalen Bild auf unserer Retina zum Beispiel einzelne Gebäude, auf denen wiederum Elemente wie Türen, Fenster oder Dächer abgrenzbar sind.

„Segmentierung ist ein grundsätzliches Problem, wenn Sie aus einem Bild einzelne Objekte auswählen wollen, für die Sie sich interessieren“, erklärt Kreshuk. „Wenn Sie zum Beispiel einen Embryo haben, der sich entwickelt, wollen Sie vielleicht jede Zelle analysieren und schauen, wie sie sich weiterentwickelt.“ In der Mikroskopie kann man Zellen über das automatisierte Segmentieren also voneinander abgrenzen – oder auch Strukturen innerhalb der Zelle wie etwa Zellkerne identifizieren. Doch zunächst beginnt alles mit Trainingsdaten: Der Algorithmus braucht Beispielbilder, die ein Mensch bereits gesehen und annotiert hat. Wer seiner Segmentier-Software also beibringen will, einzelne Zellen im Bild zu erkennen, muss zunächst selbst Bilder bearbeiten und jedem Pixel zuordnen, zu welcher Zelle es gehört oder ob es außerhalb der Zellen liegt.

Dabei ist wichtig: Die Trainingsdaten müssen auch mit dem Material vergleichbar sein, das später bei den eigentlichen Experimenten präsentiert wird. Und natürlich muss die Person, die diese Bilder annotiert, über die Strukturen auf den Bildern Bescheid wissen und selbst genügend Erfahrung haben, um möglichst fehlerfrei Objekte einzugrenzen und zu benennen. „Diese Verantwortung müssen Sie als Experimentator natürlich übernehmen“, betont Kreshuk, „und Sie müssen sorgfältig validieren“. Die trainierte Software muss also weitere bereits vom fachkundigen Menschen annotierte Bilder sehen, die aber nicht Teil der Trainingsdaten waren. Nun zeigt sich, wie viele Objekte tatsächlich korrekt erkannt oder doch übersehen werden.

Monotones Training

Die Phase des Trainings kann also aufwendig und monoton sein, räumt auch Kreshuk ein. „Aber diese ganzen Daten müssten Sie ja ohnehin generieren, um Ihre biologische Frage zu beantworten – daran führt kein Weg vorbei! Doch so haben Sie die Arbeit nur einmal für den Algorithmus und bekommen die Ergebnisse später gratis.“ Tatsächlich aber müsste gar nicht jeder Zellbiologe das Rad neu erfinden, wenn andere bereits mit ähnlichen Bildern gearbeitet haben und an denselben Strukturen interessiert waren. „Das bringt mich zu dem Punkt, warum es so wichtig ist, solche Daten auch mit anderen zu teilen“, fährt die Arbeitsgruppenleiterin fort. „Würden mehr Leute ihre Referenzdaten öffentlich hinterlegen, könnte man damit auch mehr Algorithmen trainieren, und desto weniger eigene Trainingsdaten müssten andere Forscher erstellen.“

Ein Analysetool für Mikroskopie-Aufnahmen bekommt als Input ein Bild bestehend aus den Pixeln mit ihren Helligkeitswerten und, je nach Mikroskopiermethode, auch Farbinformationen. Im Fall der Segmentierung kommt als Output wieder eine Grafik heraus. Dieses Bild enthält dann aber nur noch die Information, für die sich der Forscher interessiert. Falls es also darum geht, einzelne Zellen zu erkennen, könnte der Algorithmus eine Grafik mit Flächen in unterschiedlichen Farben ausgeben. Jede Farbe steht dann für eine individuelle Zelle.

Die Entwickler trainierbarer Algorithmen kümmern sich auch darum, was zwischen der Eingabe und der Ausgabe passiert. Beim Deep Learning haben sich die Informatiker von der Natur inspirieren lassen und das Prinzip verschalteter Neuronen und Synapsen übernommen. Eine Möglichkeit: Die Eingabeschicht, in der jedes Bild repräsentiert ist, ist mit einer zweiten Schicht vernetzt. Von dieser geht es zu einer weiteren Schicht, bis man irgendwann in der letzten Schicht – der Ausgabe – landet. An den „Synapsen“ zwischen den „Neuronen“ der einzelnen Schichten finden dann Verrechnungen statt – diese Verrechnungen passt der Algorithmus beim Lernen so lange an, bis er die Trainingsdaten stimmig analysiert (mehr zu neuronalen Netzen: Laborjournalspan> 3/2019: Seite 18, Link).

Kreshuks Team entwickelt derzeit Algorithmen, die vor allem auf einem künstlichen neuronalen Netz namens U-Net aufbauen. „Das benutzen wir, weil es funktioniert“, so Kreshuks pragmatische Begründung. U-Net wurde 2015 erstmals vorgestellt und hat einige Besonderheiten, weiß Kreshuk: „Es betrachtet die Dinge auf verschiedenen Kontextebenen. Für biologische Bilder ist das sehr wichtig, denn dann kann man etwas auf einer kleinen Skala erkennen und mit einer Information auf einer größeren Skala verbinden.“

Abkürzungen im Netzwerk

Dazu trägt ein spezielles Feature in U-Net bei, durch das sich die Architektur von anderen künstlichen neuronalen Netzen unterscheidet: Es gibt nämlich auch einige sogenannte Skip Connections; das sind Verbindungen, die von einer frühen Schicht direkt in eine späte Schicht im Netzwerk laufen. „Das ermöglicht Shortcuts im Netzwerk und macht frühe Informationen auch in späteren Stationen der Verarbeitung noch mal verfügbar“, erläutert Kreshuk.

Kreshuk sieht einen großen Nutzen darin, Algorithmen unabhängig von der konkreten Aufgabe zu entwickeln, die sie später übernehmen sollen. Ob der Nutzer die Software verwendet, um Zellen oder darin markierte Strukturen zu erkennen, entscheidet erst das Training. Bei einigen Fragestellungen könnte man auch zwei unterschiedliche Trainings-Sets verwenden und die segmentierten Bilder später wieder kombinieren – etwa weil man in Zellen einen Proteinkomplex mit GFP markiert hat und nun vielleicht die detektierten Proteinkomplexe innerhalb der Zellkerne messen will. Es gäbe dann zwei verschiedene neuronale Netzwerke, die auf eine andere Aufgabe spezialisiert sind, aber denselben Input erhalten. „Sie würden dann jeweils zwei Bilder bekommen: Eines mit den Zellkernen, ein anderes mit den Punkten“, erklärt Kreshuk. „Anschließend müsste nur noch jemand ein Skript schreiben, das in jedem Zellkern die Punkte zählt.“

Algorithmen, die das Heidelberger Team entwickelt, landen frei verfügbar auf öffentlich zugänglichen Plattformen wie GitHub. „Das ist alles quelloffen, und wir bieten auch Support an“, so Kreshuk. Ein aktuelles Beispiel, an dem auch die Heidelberger mitwirkten, ist das Programm DECODE (Nat. Methods 18(9): 1082-90).

Initiiert und geleitet wurde das DECODE-Projekt von dem Machine-Learning-Spezialisten Jakob Macke (Universität Tübingen), dem Nanomikroskopiker Jonas Ries (EMBL, Heidelberg) sowie dem Elektronen-Mikroskopie-Experten Srinivas Turaga (Janelia Research Campus, Virginia, USA). Das Tool hilft, Daten aus Mikroskopieverfahren zur Einzelmolekül-Lokalisation auszuwerten, also zum Beispiel PALM oder dSTORM (siehe Seite 36 ff.). Bei diesen Methoden blinken Fluoreszenzmarker im Mikroskop zufällig nacheinander auf. Je weniger Lichtpunkte gleichzeitig zu sehen sind, desto genauer kann man auf die Position einzelner Fluorophore schließen. Dann aber dauert die Aufnahme länger und die Probe kann ausbleichen, bevor man alle Moleküle erfasst hat. Lässt man die markierten Moleküle aber schneller aufblinken, können auch benachbarte Fluorophore gleichzeitig leuchten. Einzelne Moleküle lassen sich dann nicht mehr exakt auseinanderhalten und lokalisieren.

DECODE soll aus solchen Daten dennoch zuverlässig rekonstruieren, wo die einzelnen Lichtquellen sitzen – und das sogar bei dreidimensionalen Präparaten. In diesem Fall kann man für das Training keine realen Daten aus der Mikroskopie heranziehen – denn man weiß ja gerade nicht, wie das korrekte Ergebnis aussehen müsste. Deshalb simulierten die Autoren das Verhalten blinkender Fluorophore am Rechner und erzeugten daraus virtuelle Mikroskopie-Bilder. Denn, so begründet die Forschungsgruppe ihren Ansatz, die Physik hinter dem Einzelmolekül-Imaging sei ja gut verstanden. Anhand der simulierten Aufnahmen konnte das DECODE-Netzwerk dann für die Einzelmolekül-Mikroskopie trainiert werden.

Kreativität gefordert

Maschinelles Lernen in der Mikroskopie ist also nicht allein darauf beschränkt, Zellgrenzen oder Objekte zu erkennen. Gerade die Methoden zur zellulären Bildgebung, die das physikalisch Machbare ausreizen, fordern auch seitens der Programmierer eine Menge Einfallsreichtum. „Es ist eine großartige Zeit, um ins Feld einzusteigen“, schlussfolgert Kreshuk. „Wer Lust darauf hat, sollte mit uns Kontakt aufnehmen.”

Nun denkt man bei der Lichtmikroskopie vor allem an eukaryotische Zellen. Urs Greber hingegen schaut humanpathogenen Viren auf die Finger. „Wir erforschen seit mehr als zwanzig Jahren den Viruseintritt in die Zelle“, erklärt er, „und wir können diesen Vorgang in mehrere Schritte unterteilen“. Greber nennt den Viruseintritt per Endozytose, die Penetrierung aus dem Endosom ins Cytosol, das Kern-Docking oder den Genomimport in den Zellkern. „All diese Prozesse können wir messen.“

Grebers Arbeitsgruppe am Department Molekulare Lebenswissenschaften der Uni Zürich arbeitet mit Adeno-, Rhino- und Herpesviren – und inzwischen auch mit Coronaviren. Grebers Team haben wir vor einigen Jahren auch in einem Journal Club vorgestellt, als es einen Artikel zur Endozytose von Adenoviren veröffentlicht hatte (siehe auch Laborjournalspan> 10/2015: Seite 38-9). Herpes- und Adenoviren können latent in infizierten Zellen verweilen. Sie können sich aber auch vermehren, aus dem Kern heraus wandern und letztlich zum Absterben der Zelle durch Lyse führen. Viruspartikel werden aus der infizierten Zelle freigesetzt und befallen benachbarte Zellen. Mit Deep-Learning-Techniken haben Greber und seine Kollegen eine Software trainiert, um im Vorfeld Zellen zu erkennen, die einen lytischen Infektionsverlauf nehmen werden (iScience 24(6): 102543). „Das Problem bei einem lytischen Virusaustritt ist ja: Es gibt anschließend keine Zelle mehr, die man vermessen kann“, so Greber.

Da die Forscher die verschiedenen Subprozesse der Infektion bereits in vergangenen Arbeiten charakterisiert hatten, wussten sie, dass Herpes- und Adenoviren das Aussehen des Zellkerns und der Chromosomen verändern. Die DNA lässt sich in lebenden Zellproben leicht anfärben – in der aktuellen Studie verwendete die Gruppe den DNA-Marker Hoechst 33342. Der Algorithmus sollte an angefärbten menschlichen Lungenkrebszellen erkennen, ob sie infiziert sind oder nicht und ob sie lytisch werden. Das Virus selbst markierte die Forschergruppe zwar auch mit GFP-Konstrukten, um die neugebildeten Partikel in den Zellen verfolgen zu können – diese virusspezifischen Fluoreszenzaufnahmen bekam der Algorithmus aber nicht zu sehen. „Man wird ja nicht von fluoreszierenden Viren infiziert“, begründet Greber, und die Methode solle ja künftig auch für die Diagnostik infrage kommen – „zum Beispiel, bei immunsupprimierten Patienten“, so Greber, „denn für die kann eine Infektion mit Adenoviren gefährlich sein“.

Auf den Fluoreszenz-Bildern lässt sich der Infektionsverlauf bis zum Aufplatzen der Zellen gut verfolgen. Mit Beginn der Experimente wurden die Zellen mit Hoechst angefärbt, um die Kernstruktur hervorzuheben, und ein Foto wurde im entsprechenden Farbkanal aufgenommen. Anschließend beobachteten die Forscher jede Zelle weiter. „Wir haben Filme angefertigt und gesehen, welche Zellen lysiert wurden“, so Greber. Diese Information konnte später in die frühen Hoechst-Aufnahmen annotiert werden, um den Algorithmus zu trainieren.

Präziser als die Konkurrenz

Das trainierte Netzwerk erkannte mit Adeno- oder Herpesviren infizierte Zellen und war mit rund 95-prozentiger Zuverlässigkeit deutlich präziser und akkurater als zwei Mustererkennungsalgorithmen nach dem Prinzip der k-nearest neighbors (k-nn) sowie der Support Vector Machine (SVM), die zum Vergleich antraten und nur bei Trefferquoten um die sechzig Prozent landeten.

Der in Zürich entwickelte Algorithmus heißt ViResNet und war schon bis zu zwanzig Stunden im Voraus in der Lage, das lytische Schicksal einer infizierten Zelle zu prognostizieren. ViResNet steht bereits mit einem Set an Trainingsdaten auf Github zur Verfügung und baut auf lernenden Netzwerken auf, die Google entwickelt hat. „Wir haben gesehen, dass bereits Stunden vor dem Ereignis der Lyse eine Menge Information in den Bilddaten liegt“, resümiert Greber. Die relevanten Muster stecken anscheinend im angefärbten Chromatin der Zellen. Allerdings unterscheiden sich die Signaturen bei unterschiedlichen Viren, auch wenn beide zu einer Lyse führen. „Herpesviren brauchen einen anderen Trainingssatz als Adenoviren“, erläutert der Virologe.

„Wir sind jetzt sehr interessiert an der Infektionsvariabilität“, gibt Greber einen Ausblick auf künftige Projekte. „Wieso laufen diese Infektionen selbst in genetisch identischen Zelllinien so unterschiedlich ab?“ Greber vermutet, dass der Zeitpunkt im Zellzyklus eine Rolle spielen könnte, ebenso wie das jeweils aktuelle Metabolom, Transkriptom oder die Lipidkomposition der Zellen. „Wir wollen diese Systeme genauer unter die Lupe nehmen, und dann die Information mit Bilddaten verknüpfen.“

Bevor man einen Algorithmus wie ViResNet für klinische Anwendungen nutzt, müsse man aber weiter sorgfältig validieren und die Methode auch mit klinischem Material von Patienten trainieren und testen. Wie genau die Software Rückschlüsse aus den erkannten Mustern zieht, kann auch Greber nur mutmaßen. „In den Bildern steckt eine sehr große Menge an Information – zum Beispiel, welche Intensität ist wo, und in welchem Zusammenhang stehen sie zueinander? Strukturen haben eine bestimmte Größe, und auch die Aggregiertheit oder Körnigkeit lässt sich erfassen. Aber es gibt wahrscheinlich zu wenig Ausdrücke in der menschlichen Sprache, um all diese Informationen wirklich zu beschreiben, die hier gesampelt werden.“