Miniaturisierung im Hochdruck

Proteinreinigung und -analysemit der Flüssigchromatographie

Henrik Müller

Biowissenschaftler putzen Proteine schon seit Jahrzehnten mit der Flüssigchromatographie. Statt selbstgepackter Chromatographie-Säulen und endloser Mengen Laufmittel wie in den Frühzeiten verwenden sie inzwischen vorgepackte Säulen mit immer kleineren Innendurchmessern und raffinierterem Säulenmaterial.

Bevor Biowissenschaftler die Struktur und Funktion von Proteinen aufklären können, müssen sie diese zunächst reinigen, oder wie es im Laborslang heißt: aufreinigen. So einfach wie in Lehrbüchern beschrieben, läuft die Reinigungs-Prozedur aber nicht immer ab. Viele Jungforscher, die einen Großteil ihrer Doktorarbeit mit der Proteinreinigung zugebracht haben, können davon ein Lied singen. Glücklicherweise kann man inzwischen auf eine große Palette physikalisch-chemischer Trennmethoden zurückgreifen, die sich alle unter dem Oberbegriff Flüssigchromatographie einordnen lassen.

Die Entwicklung der Flüssigchromatographie begann farbenfroh. Im Jahr 1903 stand der russische Botaniker Mikhail Tswett mit einer Glassäule voller Polysaccharide vor der Warschauer Naturforschenden Gesellschaft. Er goss einen in Leichtbenzin gelösten Chlorophyll-Extrakt auf die Säule und wartete, bis die Schwerkraft ihren Job erledigte. Nacheinander tröpfelten schließlich unterschiedlich gefärbte Lösungsmittelzonen aus dem Ende der Säule heraus. Die Chromatographie, die wörtlich übersetzt Farbschreibung bedeutet, war geboren. Tswett hatte auch schon ihr Prinzip erkannt: „Die Methode basiert auf der Fähigkeit der gelösten Stoffe, physikalische Adsorptionsverbindungen mit verschiedenen mineralischen und festen Körpern einzugehen.“

Schnelle Kommerzialisierung

Spätestens mit den Nobelpreisen 1952 und 1972 für flüssigchromatographische Verfahren traten auch die Hersteller instrumenteller Analysegeräte auf den Plan. Sie hatten Blut geleckt und die kommerziellen Möglichkeiten der High Performance Liquid Chromatography (HPLC) erkannt. Seitdem ist die HPLC nicht mehr aus dem Labor wegzudenken und insbesondere für Molekular- und Strukturbiologen zu einem ihrer wichtigsten Arbeitspferde geworden.

Je nach Säulenmaterial werden die Makromoleküle bei der HPLC aufgrund ihrer Verteilung zwischen nicht-mischbaren Phasen, über ihre Affinität zu immobilisierten Liganden sowie durch Ionenaustauschvorgänge oder Siebeffekte getrennt. Mit der HPLC ist es aber nicht nur möglich, Biomoleküle – insbesondere Proteine – sauber auseinander zu dividieren. Sie ist auch ein wichtiges Werkzeug, um biologische, pharmazeutische und klinische Proben zu analysieren und zu charakterisieren. In Zeiten, in denen die Anforderungen an Ausbeute, Reinheit, Homogenität, strukturelle Konformität und Aktivität von Proteinen immer höher werden, ist dies vielleicht ihr größter Trumpf.

Die Trennleistung der HPLC wird durch die Van-Deemter-Gleichung beschrieben. Wer sich in die chromatographische Dispersion oder in Modelle für Trennstufenhöhen und kinetische Leistungsgrenzen einlesen möchte, dem sei der vor zwei Monaten erschienene Review der belgischen Chromatographie-Spezialisten um Sebastiaan Eeltink vom Department of Chemical Engineering der Freien Universität Brüssel empfohlen (J. Sep. Sci., 42(1)).

In der Praxis setzen vier von fünf Biowissenschaftler aber einfach auf die Affinitätschromatographie als ersten Aufreinigungs-Schritt. Dabei müssen sie die Vor- und Nachteile von gut drei Dutzend erhältlichen Affinitäts-tags abwägen. Zwar nicht topaktuell, aber dennoch empfehlenswert, um den Überblick zu behalten, sind die Reviews von Kimple et al. (Curr. Protoc. Protein Sci., 2013; 73) und Yadav et al. (Arch. Biochem. Biophys., 612: 57-77).

Affinitätschromatographischer Goldstandard ist nach wie vor die Immobilisierte-Metallionen-Affinitätschromatographie (IMAC) mit Nickel-Nitrilotriessigsäure (NTA)-Säulen zur spezifischen Abtrennung Histidin-getaggter Proteine. Hohe Bindungskapazität und Salztoleranz sowie niedrige Kosten aufgrund der einfachen Säulen-Regeneration überzeugen die meisten Biowissenschaftler.

Extreme Affinität

Keines der bisherigen Protokolle kommt allerdings ohne weitere Aufreinigungs-Schritte aus. Das nahm die Gruppe des Proteinkristallographen Dmitry G. Vassylyev von der University of Alabama zum Anlass, eine affinitätschromatographische Ein-Schritt-Aufreinigung zu entwickeln (Proc. Natl. Acad. Sci., 114(26)). Diese beruht auf der hochaffinen Wechselwirkung der inaktivierten Colicin-E7-DNase (CL7) mit ihrem Inhibitor Immunity Protein 7 (Im7). Doch warum sollte diese besser funktionieren als beispielsweise die Interaktion von Polyhistidin-Liganden mit NTA? Weil die Dissoziationskonstante des Komplexes von 10-14 bis 10-17 M selbst die meisten Antikörper blass aussehen lässt – und herkömmliche Affinitäts-Liganden wie FLAG, GST, MBP, Strep, Protein A oder Polyhistidin erst recht.

Zugegebenermaßen beeinflusst das mit dem Zielprotein fusionierte 16 kDa schwere CL7 dessen korrekte Faltung eher als ein Polyhistidin-tag. Und CL7 muss noch immer mittels SUMO- oder PreScission-Protease abgetrennt werden. Dafür erlaubt die extrem hohe Affinität von Im7 zu CL7 aber sogar die Aufreinigung aus Zell-Lysat ohne vorherige Überexpression. Selbst hohe Salzkonzentrationen, Chelatbildner und reduzierende Reagenzien sind im Gegensatz zum Polyhistidin-System kein Problem.

Die Hochleistungs-Affinitätschromatographie (HPAC) beschränkt sich aber nicht nur auf Aufreinigungszwecke. Als stationäre Phase dienen Immunoglobulin-bindende Proteine, Aptamere, Enzyme, Lektine, Transportproteine, Kohlenhydrate und Lipide in unterschiedlichen Trenn-Formaten. Die Wechselwirkungen bei diesen chromatographischen Immunoassays werden mit Fluoreszenz- und Chemilumineszenz-Techniken, thermometrisch oder elektrochemisch detektiert.

Aptamere als Liganden

So füllte beispielsweise eine südkoreanische Gruppe eine 400-Nanoliter-Mikrochip-Kammer mit Polystyrol-Mikrokügelchen, an die über eine photolytische Esterbindung RNA-Aptamere gebunden waren. Anschließend injizierten die Forscher ein Proteingemisch in die Mikrokammer, wuschen ausgiebig und eluierten spezifisch gebundene Proteine nach vorheriger UV-Spaltung. Mit dieser HPAC im Mikromaßstab reinigten die Koreaner Zielproteine, die sie dem Proteingemisch in einer Konzentration von wenigen Femtomol hinzugegeben hatten (Electrophoresis 26(3): 694-702).

Aptamere bieten aber noch weitere Vorteile. Im Gegensatz zu proteinogenen Liganden ist ihre Spezifität einfach justierbar. Zudem sind sie reversibel denaturierbar und auch in Gegenwart von Proteasen stabil.

Künstliche Membran

Inzwischen werden HPAC-Säulen sogar als künstliche Membranen eingesetzt. Die Forschergruppe um Frédéric Lynen vom Department of Organic and Macromolecular Chemistry der Universität Ghent verankerte Monolayer aus Phosphatidylcholin, Sphingomyelin und Cholesterol kovalent auf der Oberfläche von Silica-Partikeln. Damit simulierte sie die Permeabilität der Blut-Hirn-Schranke für Medikamente des zentralen Nervensystems (Ana.Bioanal. Chem., 406(25): 6179-88).

Die Belgier bestimmten die Verteilungskoeffizienten zwischen mobiler Methanol/PBS-Phase und stationärer Lipid-Phase für knapp fünfzig chemische Verbindungen. Darunter das Krebsmittel Chlorambucil, das Injektions-Narkotikum Hexobarbital und das Schmerzmittel Ibuprofen. Die Verteilungskoeffizienten des artifiziellen Systems korrelierten erstaunlich gut mit Werten, die mühevoll in Tierexperimenten ermittelt wurden. Inzwischen sind die Säulen für diese Immobilised Artificial Membrane (IAM) Chromatographie auch kommerziell erhältlich.

Günstige Impfstoffreinigung

Auch Pharmafirmen haben das Potenzial der HPAC erkannt, allen voran Impfstoffhersteller, die achtzig Prozent der Herstellungskosten für Aufreinigungs-Schritte ausgeben. Die konzeptionelle Einfachheit der HPAC und vor allem ihre Fähigkeit, Verunreinigungen effektiv zu entfernen, versprechen enorme Kostenreduzierungen.

Inzwischen ist auch die Implementierung im industriellen Maßstab in vollem Gange. So fördert zum Beispiel die EU das auf fünf Jahre angelegte Projekt DiViNe (https://divineproject.eu/) mit 5,8 Millionen Euro, in dem die Firmen iBET, Affilogic, Aquaporin, Merck KGaA, GenIbet Biopharmaceuticals und GSK kooperieren. Ziel ist es, umweltfreundliche und erschwingliche Vakzine mittels HPAC für Entwicklungsländer herzustellen.

Immer dünnere Säulen

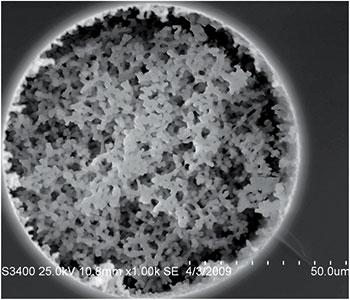

Bei chromatographischen Säulen, zum Beispiel für die Größenausschluss-Chromatographie (SEC), setzt sich die Entwicklung zu immer kleineren Innendurchmessern fort. Der Miniaturisierungs-Trend hat aber mehr als nur ästhetische Gründe. Die geringeren Volumina der sogenannten Ultra-High-Performance (UHP)-Säulen verbessern die Auflösung, steigern die Empfindlichkeit und erhöhen den Probendurchsatz. UHP-SEC-Säulen werden nicht mehr wie klassische HPLC-Säulen mit porösen 10-bis 100-µm-Silica-Partikeln beladen. Die Durchmesser der verwendeten Säulenpartikel, die nur noch auf ihrer Oberfläche eine poröse Struktur aufweisen (Superficially Porous Particles, SPP) liegen inzwischen unter 2 µm. Die Trennzeiten verkürzen sich hierdurch auf wenige Minuten.

Klingt einfach? Ist es aber nicht. Denn zahlreiche Säuleneigenschaften beeinflussen sich gegenseitig. Die chemische Zusammensetzung des Säulenmaterials, Partikelgröße und Partikelform, mechanische Festigkeit, Porengröße, interstitielles Volumen, Säulenlänge und innerer Durchmesser, Flussrate, ja selbst das Größenverhältnis von festem Partikel-Kern zum gesamten SPP-Durchmesser müssen optimiert werden.

Aus praktischer Sicht sind, nach einem Review der Gruppe um Szabolcs Fekete von der Universität Genf, aktuell 2,7 µm-SPPs mit 1.000 Å-Poren am besten geeignet, um große Biomoleküle mit hunderten kDa binnen weniger Minuten aufzutrennen (J. Pharm. Biomed. Anal., 158: 225-35).

Die Optimierung trennstarker HPLC-Säulen geht kontinuierlich weiter. Dünnere Partikeloberflächen oder Partikel aus mehreren Schichten unterschiedlicher Porengröße, sogenannte Bi-Shell Particles, versprechen noch kürzere Elutionszeiten. SPPs werden bisher hauptsächlich in SEC und Umkehrphasen (RP)-HPLC eingesetzt. Aber auch Hydrophile Interaktions-Chromatographie (HILIC) und Ionenaustausch-Chromatographie (IEX) profitieren von dieser Entwicklung. So sind bereits HILIC-Säulen mit 2,6 µm SPP, etwa zur Polysaccharid-Analyse erhältlich.

Ein weiterer Trend ist die Verwendung monolithischer Säulenpackungen mit schwammartigen Strukturen, die durch die Polymerisation von Monomeren gewonnen werden. Monolithen haben eine Reihe von Vorteilen gegenüber Partikel-basierten Trägermaterialien. So lässt sich zum Beispiel ihre Porosität und Porengröße maßschneidern und auf Trenngeschwindigkeit oder Effizienz trimmen. Hinzu kommt, dass man die Polymerisationsmischung in beliebige Formen gießen kann, um zum Beispiel dicke präparative oder filigrane analytische Säulen herzustellen.

Höhere Flussraten

Da monolithische Phasen außerdem höhere Flussraten ermöglichen und bessere Trenneigenschaften besitzen, dürfte ihnen die Zukunft gehören. Kopfschmerzen bereitet den Säulenherstellern aber noch die strukturelle Inhomogenität der Monolithe. Diese führt zur sogenannten Wirbeldiffusion, die Analyte nicht linear sondern im Zickzackkurs durch das Trennbett wandern lässt. Die Folge ist eine unschöne Bandenverbreiterung. Dennoch offerieren alle großen Säulenanbieter monolithische LC-Säulen zur Protein-Identifikation. Einige Auguren schätzen den Marktumfang für Chromatographie-Säulen im Jahr 2024 auf knapp drei Milliarden Euro. Wer die strukturelle Inhomogenität als erstes in den Griff bekommt und monolithische Säulen mit einer verbesserten Trennleistung anbieten kann, könnte sich eine goldene Nase verdienen.

Auch weitere Spielarten etwa die Superkritische Flüssigkeitschromatographie (SFC) oder die Mixed-Mode-Chromatographie (MM-HPLC) warten nur darauf, für die Trennung und Analyse biologischer Makromoleküle eingesetzt zu werden. MM-Säulen vereinen das Prinzip des Ionenaustauschs mit dem Trennmechanismus der RP-HPLC. Mit ihnen ist es möglich, rekombinante Proteine ohne Liganden in einem Schritt aufzureinigen.

Einen Überblick zur MM-HPLC erhält man zum Beispiel in einem Review der Chromatographie-Spezialisten Kelly Zhang und Xiaodong Liu von den Firmen Genentech beziehungsweise Thermo Fisher Scientific (J. Pharm. Biomed. Anal., 130, 19-34).

Verlustquelle Nummer eins während der Aufreinigung von Proteinen ist nach wie vor die Protein-Aggregation. Mit den Liganden, die Vasiliki Paraskevopoulou und Franco Falcone in Tabelle 1 ihres Reviews aufführen, lässt sich die Löslichkeit vieler Zielproteine jedoch erhöhen – auch wenn ihre Vielzahl den Leser zunächst schier erschlägt (Microorganisms 6, 47).

Häufig ist der letzte Aufreinigungs-Schritt dennoch eine SEC zur Abtrennung unerwünschter Aggregate. Die SEC ist auch das beliebteste Werkzeug zur Quantifizierung der Größenverteilung und Aggregationskinetik von Monomer-Oligomer-Gemischen. In Kombination mit UV- und Fluoreszenz-Detektion, Mehrfachwinkel-Lichtstreuung (MALS), dynamischer Lichtstreuung (DLS) oder Elektrosprayionisation (ESI)-Massenspektrometrie (MS) erlaubt sie nicht nur die Charakterisierung von Proteinstrukturen höherer Ordnung. Auch Fragmente, molekulare Verunreinigungen und posttranslationale Modifikationen können im Handumdrehen identifiziert werden.

Kurze Trennzeiten

Selbst konformationelle Änderungen gelöster Proteine kann man mit der SEC erkennen (J Chromatogr A, 1496, 51-57). Damit steht dem Hochdurchsatz-Screening von Proteinchargen nichts mehr im Weg. Die kurzen Trennzeiten moderner UHP-SEC-Säulen erlauben es, nach Reinheit, Homogenität und struktureller Konformität zu selektionieren, um damit zum Beispiel enzymatische Reaktionen effizient zu optimieren. Genauere Infos zu modernen UHP-SEC-Säulen findet man im Review von Szabolcs Feketes Gruppe (J. Pharm. Biomed., 158, 225-235).

Auch bei der analytischen HPLC ist die Miniaturisierung der Partikelgröße das heiße Thema der letzten Jahre. Üblich sind inzwischen Sub-2 µm-Silica-Partikel, die häufig mit Octadecylsilan (C18-Säulen) derivatisiert sind. Im gleichen Maß wie die Partikelgrößen schrumpfen auch die Innendurchmesser der Säulen. Bei der sogenannten Nano-HPLC werden statt der üblichen 4,6 Millimeter Innendurchmesser mittlerweile Säulen mit weniger als 0,1 Millimeter verwendet. Unter Hochdruck werden 200 bis 300 Nanoliter Laufmittel pro Minute durch die Kapillaren gepumpt. Da die Analyten in diesen winzigen Volumina stärker konzentriert sind, kommen am Detektor, üblicherweise ein Massenspektrometer, auch mehr an.

Nano-HPLC

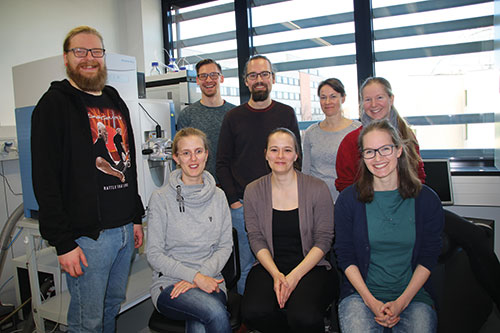

Carla Schmidt, die am Zentrum für Innovationskompetenz HALOmem der Martin-Luther-Universität Halle-Wittenberg (MLU) eine Nachwuchsgruppe leitet, meint dazu: „Für die Nano-HPLC braucht man heutzutage kein Spezialist mehr sein. Etliche kommerzielle Hersteller bieten Baukastensysteme an, mit denen man auf hohem Niveau Forschung betreiben kann.“ Die rasante Entwicklung von Flüssigchromatographie und Massenspektrometrie (LC-MS) ist für sie ein Segen. „Früher musste ich noch ständig den Schraubenschlüssel in die Hand nehmen. Heute nur noch, falls mal etwas kaputt geht.“

Moderne Nano-LC-Systeme, die zumeist mit Massenspektrometern kombiniert werden, nehmen den Benutzern das gröbste ab. Schmidt nutzt sie, um Protein-Lipid-Komplexe der synaptischen Membran zu untersuchen. Dazu vernetzen ihre Mitarbeiter direkte Kontaktstellen innerhalb der Komplexe chemisch, verdauen sie dann proteolytisch und trennen die gespaltenen Peptide mithilfe der SEC/Nano-HPLC/MS.

„Die Informationen aus den Datenmengen, die wir damit erhalten, haben wir längst noch nicht ausgeschöpft.“ Lachend fügt sie hinzu: „Letzte Woche haben wir in einer vierstündigen Nano-HPLC mit einem Lösungsmittel-Gradienten das gesamte Hefeproteom aufgetrennt. Viel länger werden wir brauchen, es auch nur ein wenig zu verstehen. An die Myriaden posttranslationaler Modifikationen will ich noch gar nicht denken...“ Klingt so, als sei die Nano-HPLC in Proteomik, Lipidomik und Glykomik bereits heute unverzichtbar geworden.

Noch etliche Baustellen

Was aber nicht heißen soll, dass es keine Baustellen mehr gibt. „Die heutige Analysesoftware ist viel benutzerfreundlicher. Trotzdem benötigen Routinearbeiten wie die Datenprozessierung noch zu viel Zeit“, erklärt Schmidt. „Auch bei Eigendiagnose und -wartung muss noch mehr automatisiert werden. Das ist noch zu viel Fummel-Arbeit. Sobald man sich von Standardeinstellungen wegbewegt, ist die Reproduzierbarkeit noch immer ein Problem.“

Für komplexe Mischungen verwendet Schmidt die sogenannte zweidimensionale (2D)-HPLC, bei der zwei Trennsäulen miteinander verknüpft werden. Der Trick besteht darin, das Eluat der ersten Dimension über ein Modulationsventil auf eine weitere Trennsäule zu leiten. Wird das komplette erste Eluat fraktionsweise aufgetrennt, spricht man von comprehensive 2D-LC oder LCxLC. Werden nur bestimmte Fraktionen gezielt für die zweite Dimension injiziert, ist von heart-cutting 2D-LC oder LC-LC die Rede. Letzteres spart natürlich enorm viel Zeit.

Schmidt separiert die Spaltpeptide zunächst mit der SEC nach ihrem hydrodynamischen Radius. Dann ordnet sie sie mittels Nano-RP-HPLC nach ihrer Hydrophobizität. Die 2D-Trennleistung ist um ein Vielfaches höher als die der einzelnen Säulen, da sich ihr Auflösungsvermögen multipliziert. Was umso besser funktioniert, je verschiedener beide Trennmechanismen sind. Üblicherweise folgt auf Ionenaustausch- oder hydrophile Interaktions-Chromatographie eine RP-HPLC. Verwendet man die RP-HPLC in beiden Dimensionen, variiert man in einer Dimension den pH-Wert. Die RP-HPLC ist in der zweiten Dimension besonders beliebt, weil die benötigten Säulen schnell und zu verschiedenen Lösungsmitteln passend erhältlich sind.

Schnell und effektiv

Die Zeitersparnis mit der 2D-HPLC ist beträchtlich, wodurch sich unterer anderem auch die Betriebskosten reduzieren. Die gewonnene Zeit ist aber nicht der einzige Vorteil. Sind in dem zu trennenden Gemisch zum Beispiel Verbindungen mit mehreren chiralen Zentren enthalten oder besteht es aus einer Mischung von Wirkstoff und Benetzungs-Mittel, gelingt es mit der 1D-LC häufig nicht mehr, die einzelnen Bestandteile sauber zu trennen.

Mittlerweile haben kommerzielle 2D-LC-Systeme ihre selbst zusammengeschusterten Pendants in vielen Laboren abgelöst. Auch in den Forschungs- und Entwicklungsabteilungen der biopharmazeutischen Industrie erfreut sich die 2D-HPLC zunehmender Beliebtheit. Inwieweit 2D-LC-Methoden den Sprung in industrielle Umgebungen schaffen werden, in denen Qualitätssicherung und Good Manufacturing Practice maßgeblich sind, muss man aber sehen. Ohne Zweifel werden Forscher jedoch daran arbeiten, die Reproduzierbarkeit, Präzision und Flexibilität der 2D-HPLC in den nächsten Jahren systematisch zu verbessern. Und wer weiß, wie viele Dimensionen dann noch hinzukommen.

Um die grundlegenden Funktionseinheiten eines Organs möglichst naturgetreu nachzubilden, genügt ein kleiner dreidimensionaler Ausschnitt des Gewebes. Bringt man diesen auf einem durchscheinenden Plastik-

Chip unter, kann man die Funktionsweise des Organs wie durch ein Fenster beobachten.

Nicht immer benötigen Biowissenschaftler Ratten oder andere Versuchstiere, um Antworten auf ihre Fragen zu finden. Zellkulturen und nachgebildete Gewebe sind nützliche Alternativen, die nicht nur ethische Bedenken umgehen, sondern mitunter auch mehr Informationen liefern – sowohl qualitativ als auch quantitativ. Dass im Tiermodell nicht alles so abläuft wie beim Menschen, ist keine neue Weisheit. Die wirksame oder tödliche Dosis berechnet sich nun einmal nicht nach dem Körpergewicht, und viele Substanzen werden je nach Spezies anders verstoffwechselt – im Tier- wie im Pflanzenreich.

Auch die personalisierte Medizin funktioniert nicht im Tiermodell, weil niemand weiß, welcher Hamster oder welche Maus den Krebsverlauf und die Chemotherapie-Reaktion eines Patienten realitätsnah simuliert. Das geht nur mit Zellen oder Gewebe des Patienten selbst.

Möglichst authentisches Modell

Um die Prozesse, die sich darin abspielen, so authentisch wie möglich abbilden zu können, verwenden Forscher zunehmend dreidimensionale (3D) Zellkulturen. Gründe hierfür gibt es zuhauf: In 2D-Zellkulturen wachsen alle Zellen in einer flachen Schicht und haben Kontakt zur Umgebung. In echten Organen erfahren dagegen nur die Oberflächen-Zellen die Außenwelt direkt. Die Zellen im Inneren kommunizieren untereinander, geben Substanzen teilweise verstoffwechselt an ihre Nachbarzellen weiter und teilen sich weniger als die äußeren.

Sollen Zellkulturen auch in der dritten Dimension wachsen, benötigen sie ein Gerüst, etwa aus Kollagen, Fibronektin oder Alginat, das der extrazellulären Matrix (ECM) von Geweben ähnelt. Damit 3D-Kulturen aber länger als nur ein paar Stunden oder Tage überleben können, müssen sie regelmäßig mit Nährstoffen versorgt werden. Gleichzeitig müssen nicht mehr benötigte Stoffwechselprodukte entsorgt werden.

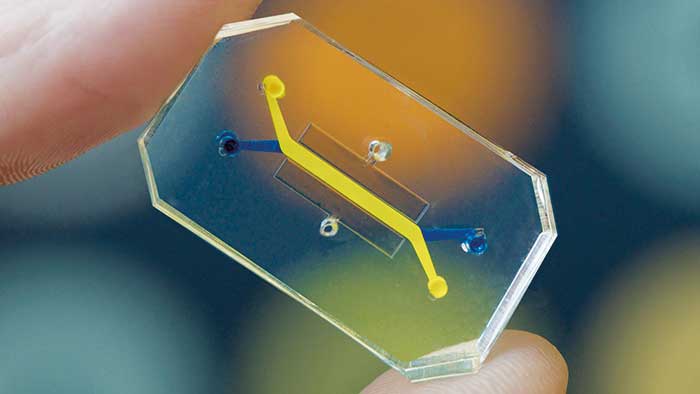

Besonders einfach und dennoch sehr nah an der Realität gelingt dies, wenn man die Zellen auf speziellen Organ-Chips (Organ-on-Chip, Organs-on-a-Chip) kultiviert, die echte Organe nachahmen und meist nicht größer sind als eine Euromünze. Die Chips enthalten winzige Kanäle, Pumpen und Ventile, über die die Zellen mit Blut oder Nährlösung versorgt werden. Das einfachste Organ-Chip-Modell enthält zwei Mikrokanäle, die wie ein kurzes zweiadriges Stromkabel aussehen, dessen Stromleitungen an den Enden Ypsilon-förmig aufgetrennt sind. Im dazwischen liegenden Abschnitt sind sie jedoch übereinander angeordnet und verlaufen parallel. An den Enden können Testsubstanzen in die Mikrokanäle appliziert werden, die in den parallel verlaufenden Abschnitt des Kanals wandern. Von dort können sie über eine poröse Membran in den benachbarten Kanal gelangen.

Es ist möglich, zwei Zelltypen gleichzeitig in den beiden Kanälen des Organ-Chips zu kultivieren, die durch eine Membran getrennt sind. Ein Zelltyp repräsentiert das nachzubildende Organ, beziehungsweise ein Gewebe, das eine organspezifische Funktion erfüllt (Parenchym). Der andere bildet einen mit Endothelzellen ausgekleideten Kanal der ein Blutgefäß nachahmt.

Gewundene Kanäle

Von diesen minimalistisch aufgebauten Organ-Chips existieren inzwischen verschiedene optimierte Varianten. Bei diesen winden sich die etwa zehn Nanometer dicken Mikrokanäle meist in engen Kurven, ähnlich wie bei einer Heizspirale. Wozu die engen Windungen? Flüssigkeiten fließen als laminare Strömung in Schichten durch die Mikrokanäle. In einem geradlinig verlaufenden Kanal verteilen sich die in den Flüssigkeiten gelösten Substanzen sehr schlecht. Die Kurven in den gewundenen Kanälen verursachen jedoch winzige Verwirbelungen, die dazu führen, dass sich die Moleküle besser verteilen können.

Die Herstellung der Organ-Chips ist gar nicht so kompliziert, wie manche vielleicht denken. Früher wurden dazu meist lithographische Verfahren eingesetzt. Heute verwendet man in der Regel einen 3D-Drucker, der nach einer Vorlage klar definierte Strukturen produziert, die weitere Feinarbeiten ersparen.

Der Drucker stellt aber nicht den eigentlichen Chip her, sondern nur eine Gießvorlage, die mit einem geeigneten Kunststoff ausgegossen wird. Das Gießmaterial muss sehr viele verschiedene Anforderungen erfüllen und entsprechend sorgfältig ausgewählt werden. Wichtige Kriterien sind zum Beispiel: Druck- und Temperaturbeständigkeit, Robustheit und Dehnbarkeit. Zudem muss es möglichst inert und mit lebenden Zellen kompatibel sein –und natürlich auch kostengünstig.

Optimal wäre ein Material, von dem die Zellen in ihrer künstlichen Behausung gar nichts mitbekommen und in dem sie sich wie in einem echten Organ fühlen. Das ist natürlich reines Wunschdenken: Ein Material, das für alle Organ-Chip-Anwendungen passt und mit dem sich die Ergebnisse von Organ-Chip-Experimenten unmittelbar vergleichen ließen, gibt es nicht.

Einfaches Kunststoff-Gehäuse

Die meisten Forscher favorisieren jedoch den Kunststoff Polydimethylsiloxan (PDMS) für die Herstellung von Organ-Chips. PDMS besteht aus linearen Polymeren, die sich durch Quervernetzungen in Elastomere verwandeln. Je nach Grad der Vernetzung lässt sich die Viskosität und Elastizität des Kunststoffs variabel einstellen. PDMS wird zum Beispiel auch als Gleitbeschichtung von Kondomen benutzt, oder für Wurzelkanalfüllungen beim Zahnarzt.

Der Kunststoff ist nicht nur als Baumaterial für die Gehäuse und Mikrokanäle von Organ-Chips geeignet, sondern auch für die Membranen. Hierfür wird flüssiges PDMS hauchdünn auf eine Art Miniatur-Waffeleisen gegossen, gepresst und ausgehärtet. Entsprechend den Waffeleisen-Erhebungen ist die fertige Membran dann von regelmäßig angeordneten winzigen Poren durchzogen. Sehr anschaulich ist der gesamte Herstellungsprozess bis hin zum fertigen Organ-Chip in einem Paper des Organ-Chip-Spezialisten Donald Ingber vom Whyss Institute for Biologically Inspired Engineering, der Harvard University beschrieben (JoVE, 140, e58151).

Zellen können einziehen

Ist das Gehäuse des Organ-Chips gegossen und ausgehärtet, muss es mit den gewünschten Zellen besiedelt werden. Hierfür verwenden Forscher immortalisierte Zelllinien oder induzierte pluripotente Stammzellen (iPS). Bei primären humanen Zellen, die einem Patienten zum Beispiel bei einer Organresektion entnommen wurden, ist Vorsicht geboten. Der Patient, inklusive seiner Organe, hat meist schon verschiedene Medikamentenbehandlungen durchlebt und das Probenmaterial ist nicht mehr „jungfräulich“ – je nachdem, von welcher Position im Organ die Probe stammt, variieren die Eigenschaften. Induzierte pluripotente Stammzellen des Patienten sind hierfür weitaus besser geeignet. Je nach Kultivierungsbedingung lassen sie sich in den gewünschten Zelltyp differenzieren. Die Parenchym-Zellen, die ein bestimmtes Organ nachbilden sollen, werden im obenliegenden Kanal des Chips deponiert. Prinzipiell sind verschiedenste Zelltypen für die Besiedelung des Kanals denkbar. So wurden bereits Organ-Chips hergestellt, die Herz, Hirn, Darm oder Lunge nachbilden.

Auch bei der Entwicklung von Tumor-Chips gibt es erste Erfolge. Ziel ist es, die Mikro-Umgebung von Krebszellen nachzustellen, in der sie physisch und chemisch miteinander interagieren. Tumor-Chips sind insbesondere für das Screening von Krebsmedikamenten interessant. Noch spannender wird es, wenn man den Tumor-Chip mit einem anderen Organ-Chip koppelt, um zum Beispiel die Auswirkungen von Leberkrebs auf Darm, Niere, Milz oder andere Organe zu verfolgen.

Atmender Lungen-Chip

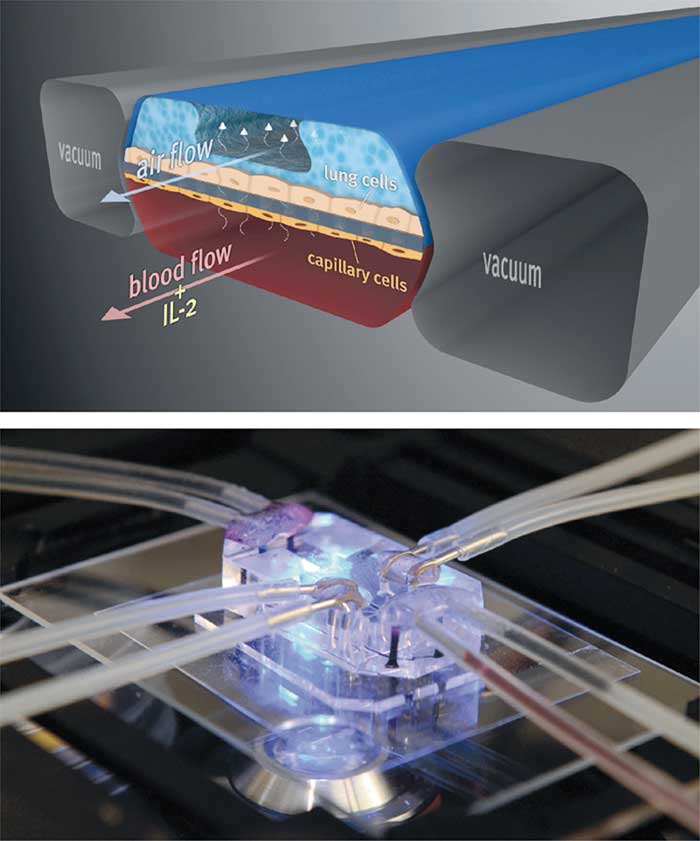

Wie man einen Lungen-Chip herstellen kann und wie dieser aufgebaut ist, zeigt Donald Ingbers Team in einem Video, das auf der Webseite der Gruppe zu finden ist. Der Chip basiert auf dem Standardmodell mit zwei Mikrokanälen, die durch eine poröse Membran getrennt sind. Auf der oberen Membranseite ist eine Schicht aus Lungenepithelzellen angesiedelt, auf der unteren eine Lage Endothelzellen, die für gewöhnlich Blutgefäße auskleiden. Durch den oberen Kanal strömt Luft, durch den unteren Blut. Über die Poren gelangen Bestandteile des Bluts in den oberen Kanal. Die Kommunikation zwischen den zwei Zelltypen ist damit schon mal sichergestellt.

Aber eine Lunge atmet auch. Je nach Alter, Kondition und sportlicher Belastung durchläuft das Lungengewebe 6 bis 64 Schlaff-Straff-Zyklen pro Minute. Diesen Rhythmus muss auch der Lungen-Chip simulieren. Ingbers Team erreicht dies mit einem raffinierten Trick: Links und rechts des Luft-Blut-Doppelkanals verlaufen zwei parallele Kanäle, an die ein Vakuum angelegt werden kann. Unter Vakuum dehnt sich das flexible Material des Luft-Blut-Doppelkanals aus – inklusive der Membran und dem darauf haftenden Zellgewebe. Ohne Vakuum entspannt es sich wieder. Über das Vakuum wird so die Atemfrequenz einer Lunge simuliert.

Wie beim echten Atmen erleichtern die verringerte Dicke und die vergrößerte Fläche der Membran bei der Dehnung Luftschadstoffen den Zugang. Mit Lungen-Chips könnte man deshalb zum Beispiel die Auswirkungen von Luftschadstoffen auf die Lunge analysieren. Durch den Mikrokanal für den Lufttransport kann man Gase, die einzelne Schadstoffe oder ganze Giftcocktails enthalten, über das Epithelgewebe leiten und etwaige Auswirkung biochemisch oder mikroskopisch untersuchen.

Differenzierte Analyse

Auf diese Weise ließe sich nicht nur die unmittelbare Antwort der Epithelzellen abfragen, etwa über die Expression von Marker-Genen, den programmierten Zelltod oder Metabolit-Veränderung – man könnte auch die Reaktionen direkt im Blut analysieren. Wie reagiert das Gewebe zum Beispiel auf ein Teilchen, das im Luftstrom transportiert wird? Wird es abgewehrt oder zerstört? Um diese Fragen beantworten zu können, leitete Ingbers Gruppe E. coli-Zellen durch den Luftkanal des Lungen-Chips, die eine Infektion vortäuschen und eine Immunantwort auslösen sollten. In den Blutstrom speiste das Team Leukozyten ein, die mit einem Fluoreszenz-Marker versehen waren. Was passierte? Die Bakterien setzten sich an einigen Stellen auf dem Lungenepithel ab. Das hierdurch ausgelöste Signal gelangte über die durchlässige Membran in den Blutstrom und alarmierte die Leukozyten. Diese machten sich über die Membran auf den Weg zu den attackierten Epithelzellen und eliminierten die Bakterien.

Näher an der Realität

Wie wichtig die eingebaute Atem-Rhythmik für Experimente mit Lungen-Chips ist, zeigt eine Studie, die Ingbers ehemaliger Schüler Dan Huh vom Engineering Systems Laboratory der University of Pennsylvania mit dem Lungen-Chip durchführte (Ann Am Thorac Soc. 12 (Suppl 1): S42-44). Huh leitete toxische Nanopartikel durch den Luftkanal über die Epithelzellen und verfolgte ihren weiteren Weg. War die Atem-Rhythmik eingeschaltet, wanderten wesentlich mehr Nanopartikel in den unteren Blut-durchflossenen Mikrokanal. Das „atmende“ Lungen-Chip-System bildet die Realität bei Toxizitätstests also weit besser ab als ein „starres“ Lungen-Zellkultursystem.

Zellkommunikation funktioniert

2014 gründete Ingber das Spin-off Emulate, das neben Lungen- auch Darm-Chips entwickelt. Faszinierend ist, wie naturnah sich die Zellgewebe-Kulturen im Mikrokanal verhalten. Deponierten die Forscher Zellen der menschlichen Darm-Innenwand auf dem Organ-Chip, so formierten sich diese ganz von selbst zu faltigen Gebilden, die „echten“ Darmfalten ähnelten. Offensichtlich funktioniert die Kommunikation zwischen den Zellen – mit statischen 2D-Kulturen wäre das ein Ding der Unmöglichkeit. Zudem kann der obenliegende Kanal mit einem definierten Darm-Mikrobiom ausgestattet werden, um den Einfluss auf die Immunantwort zu simulieren. In 2D-Kulturen würden sich die Bakterien und Pilze einfach als Rasen über Zellen und Nährstoffe hermachen.

Aber nicht nur in den USA arbeiten akademische und industrielle Arbeitsgruppen an Organ-Chips. Auch hierzulande sowie in der Schweiz und Österreich versuchen Forscher mithilfe von Organ-Chips, die Strukturen und Prozesse in Organen möglichst exakt abzubilden. Zu diesen zählt auch Günter Lepperdinger, der an der Universität Salzburg die Funktion mesenchymaler Stammzellen bei Alterungsprozessen untersucht. Lepperdinger gründete die Initiative System-Precision-on-Chip Laboratories (SPOC Labs), mit der er die Herstellung von Organ-Chips und anderen Mikrofluidik-Geräten nach industriellen Standards vorantreiben will.

Fehlende Standards

In fehlenden Standards sieht Lepperdinger das größte Problem für die stärkere Verbreitung von Organ-Chips in Forschungs-Laboratorien. „Es gibt weltweit“, so Lepperdinger, „nur sehr wenige Zentren, die sich auf das Design, den Prototypenbau und die Produktion von Biochips für den Routinegebrauch verstehen. Deshalb scheitert oftmals die Umsetzung einer guten Idee an der technischen Machbarkeit oder zu geringen Erfahrungswerten. In den SPOC Labs können Prototypen in kleinen Serien kostengünstig und schnell gefertigt und Organ-on-Chip-Lösungen in Forschungslaboren mit High-End-Untersuchungsmethoden getestet werden. Die ‚humanisierten Organversuche‘ werden in Salzburg aber nicht einfach nur mit den Ergebnissen aus gängigen Tierversuchsmodellen verglichen, die derzeit vor allem aus kurzlebigen Arten wie Mäusen bestehen. Wir untersuchen vor allem Fragestellungen, die für die alternde Gesellschaft relevant sind: Viele Krankheiten treten bei langlebigen Arten erst dann auf, wenn die Labortiere normalerweise gar nicht mehr leben. Für die Organ Rekonstruktion verwenden wir deshalb im SPOC Lab gealterte menschliche Stammzellen (Trends Biotechnol 32(5): 245-53).“

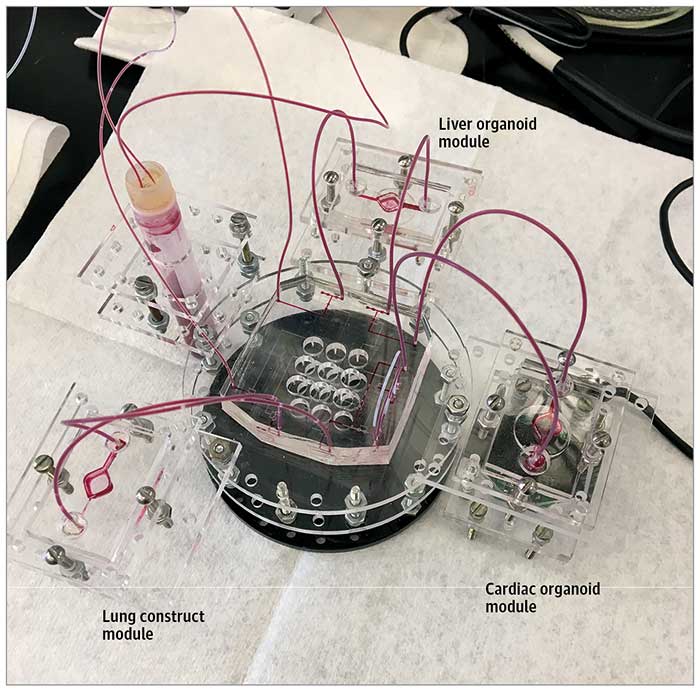

Ein weiterer Schritt auf dem Weg zu möglichst realitätsnahen Modellsystemen sind Multi-Organ-Chips. Wenn man ein einzelnes Organ nachahmen und mit einem Kanalsystem versorgen kann, so müssten sich auch weitere Organe daran anschließen lassen.

Multi-Organ-Chip

Als Basis dient auch hier ein Mikrokanal, der als Blutgefäßsystem fungiert. Anders als auf einem Einzel-Organ-Chip hat der Kanal kein unmittelbares Ende, sondern geht in den Endothel-ausgekleideten Mikrokanal des benachbarten Chips über. Das hindurch fließende Blut trifft auf keine Barrieren, kann also Substanzen von einem Organ-Chip zum nächsten transportieren. Ein im Leber-Chip verstoffwechseltes Medikament wandert zum Beispiel zum Nieren-Chip. Dort wird es unter Umständen andere (Neben-)wirkungen hervorrufen, als es dies an einem einzelnen Nieren-Chip getan hätte. Solche Konstellationen helfen also, Nebenwirkungen von Medikamenten auf Nicht-Ziel-Organe zu testen.

Mit jedem weiteren Chip, der angehängt wird, tauchen jedoch immer mehr Unbekannte auf, etwa die Kanaldicke, relative Organgrößen sowie unterschiedliche Lebensdauer der Zellen. Bei Mikrokanälen mit gerade mal zehn Mikrometern Durchmesser werden Oberflächeneffekte mit wachsender Kanallänge zum Problem – hier und da bleiben applizierte Substanzen oder zu messende Produkte an den Kanalinnenflächen hängen. Nicht minder heikel sind die Größen der zu verknüpfenden Organe. Soll man sie relativ zum Organgewicht im echten Organismus festlegen und zum Beispiel jeweils ein Tausendstel Niere und ein Tausendstel Leber verwenden?

Welches Größenverhältnis?

Auf dem Chip weichen Form, Durchblutung und Tot-Raum (clearance volume) eines Organs von den Werten im Organismus ab. Eine Gruppe um Stacy Sherrod von der Vanderbilt University in Nashville, USA, schlug deshalb bestimmte Parameter als Bezugsmaßstab vor, welche die entsprechenden funktionalen Aktivitäten eines Organs widerspiegeln: Etwa das Pumpvolumen für das Herz oder das ausgetauschte Gasvolumen für die Lunge.

Organ-Chips haben großes Potenzial. Es sind aber noch einige Hürden zu überwinden, bevor sie Tierversuche ersetzen sowie Routine-Aufgaben in der personalisierten Medizin oder im Medikamentenscreening übernehmen können. Ein Problem ist die schlechte Haftung der Zellen an PDMS. Werden zum Beispiel Endothelzellen vom Blut- oder Nährlösungsstrom teilweise weggespült, entsteht an der Kanalverkleidung eine Lücke. Abhilfe könnte ein Überzug des PDMS-Chip-Materials mit Kollagen schaffen. Dann tritt man aber schon in das nächste Fettnäpfchen, da das Zellverhalten durch das Unterlagen-Material beeinflusst werden kann. Unter Umständen wechselt eine Zelle auf einen anderen Stoffwechselweg, was wiederum bei Medikamententests zu gänzlich abweichenden Ergebnissen führen würde.

Zu kurzes Leben

Die nächste Hürde ist die Lebensdauer. Die Zellen auf Organ-Chips halten zwar länger durch als 2D-Zellkulturen, dennoch sind sie ziemlich kurzlebig. Ein paar Tage reichen für Langzeit-Studien zu Medikamenten-Wirkungen nicht aus, ganz zu schweigen von Experimenten zur Zellalterung.

Ein weiteres Manko ist die Reproduzierbarkeit beziehungsweise das Fehlen eines gemeinsamen Standards. Viele Organ-Chip-Forscher gehen ihren eigenen Weg bei der Optimierung ihrer Systeme. Das macht den Vergleich von Ergebnissen schwierig. Für Pharmatests bräuchte es einen klar definierten Standard, der verschiedene Fragen beantwortet –etwa: Welches Chip-Material wird verwendet? Wie viele Zellen werden eingesetzt? Aus welcher Quelle stammen sie? Und wie groß ist die Fläche, auf der sie wachsen?

Nötiger Konsens

Zumindest für den prinzipiellen Aufbau von Organ-Chips sollte ein Konsens erreichbar sein. Etwa indem man einheitliche Schablonen für das PDMS-Gießen sowie Protokolle für die Chip-Zusammensetzung und Befüllung festlegt. Auch bei den Versorgungsmedien sollte man sich darauf einigen können, ob man zum Beispiel Blut oder Nährlösung verwendet.

Last but not least gibt es auch ein logistisches Problem. Zwar sind Organ-Chips wunderbar handlich, doch für manche Auswertungen sind umfangreiche Hightech-Geräte nötig. Selbst wenn ein Labor also einen Chip selbst zusammenzimmert, Zellen kultiviert und behandelt: Die Autonomie hört auf, sobald komplexere Analysen gefragt sind.

Letzte Änderungen: 06.02.2019