Mit vereinten Kräften zur Sequenz

Methoden-Special: Next und Third Generation Sequencing

Karin Hollricher

(13.09.2021) 20. August, Redaktionsschluss. Heute schwimmt ein Fetzenfisch über die Titelseite von Science Advances und kündet von der ersten De-novo-Genomsequenz dieses faszinierenden Tieres. 660 Millionen Basen. Eine moderne Maschine bewältigt das lässig an einem Tag. Ist das zu fassen? Ein Blick in die dynamische Welt der Sequenzierer.

Vor zwanzig Jahren konnte die Welt erstmals die Sequenz eines menschlichen Genoms lesen. Gut, es war noch eine vorläufige, unvollständige und durchaus fehlerhafte Version, aber das schmälerte den Erfolg des Humangenomprojekts (HGP) nicht. Die drei Milliarden Basen kosteten damals um die 300 Millionen US-Dollar. Heute kann man ein besseres Ergebnis für nur 1.000 US-Dollar bekommen – dank der Entwicklung völlig neuer Sequenziermethoden, deren Grundprinzipien ab Seite 76 kurz zusammengefasst werden. Manche Technologien, etwa Illumina (Solexa), kamen vergleichsweise schnell in die Labore, andere wie PacBio und Oxford Nanopore Technologies brauchten länger. Manche hielten sich, wieder andere – beispielsweise die 454-Pyrosequenzierung von Roche – verschwanden von der Bildfläche. Einige, etwa Agilent, konzentrieren sich auf klinische Diagnostik, andere sind eher im wissenschaftlichen Feld mit dem Whole Genome Sequencing (WGS) unterwegs. Forscher sequenzieren ganze Genome, Metagenome, Exome oder gezielt ausgewählte und angereicherte Genomabschnitte (targeted sequencing). Sie generieren Genome de novo, suchen aber auch nach Punkt-Mutationen, Variationen von Genkopien und strukturellen Varianten.

Große Bandbreite

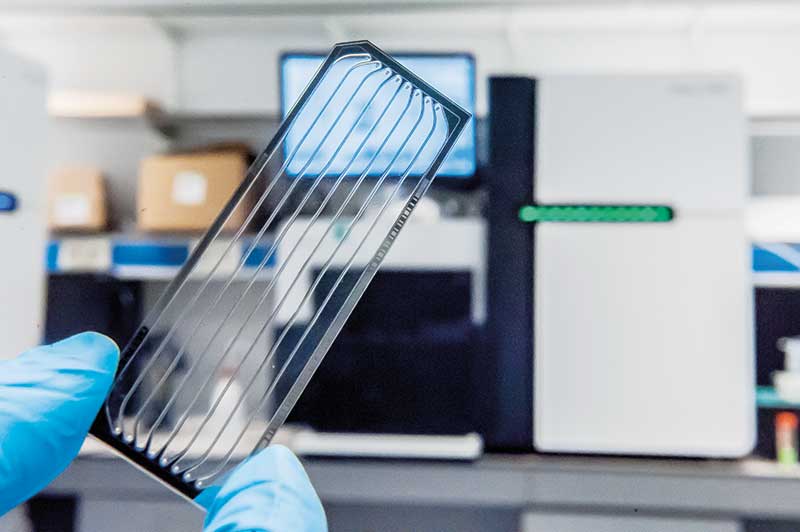

So unterschiedlich die Technologien sind, so verschieden sind auch die Geräte: Die Bandbreite reicht vom Instrument in der Größe eines USB-Sticks bis zur Maschine im Schrank-Format. Es sind nicht viele Gerätehersteller, dafür umso mehr Lieferanten von Verbrauchsmitteln auf dem kräftig wachsenden Sequenziermarkt unterwegs. Die Marktanalyse-Firma MarketsandMarkets prognostiziert ein Wachstum von 10,3 auf 24 Milliarden US-Dollar in den kommenden fünf Jahren. Dafür seien nicht nur sinkende Kosten verantwortlich. Das Wachstum sei auch getrieben von der zunehmenden Diagnostik individueller Tumore und der COVID-19-Pandemie. Beispielsweise habe Oxford Nanopore Technologies (ONT) im vergangenen Jahr 200 MinION-Geräte nach China für das SARS-CoV-2-Überwachungsprogramm geliefert.

Puh, wie will man diese Vielfalt in einem Artikel abhandeln? Nach Technologie? Nach Anwendung? Oder exemplarisch an einem Genom?

Der Autorin war die letzte Variante am sympathischsten, und so wählte sie das Gerstengenom. Es besteht im haploiden Satz aus sieben Chromosomen, ist knapp fünf Milliarden Basen lang und steckt voller repetitiver Abschnitte. Diese Eigenschaften machen die Pflanze nicht wirklich zu einem idealen Kandidaten für ein Sequenzierprojekt.

Unerschrockene Forscher ließen sich trotzdem nicht aufhalten. Einer dieser Recken ist Nils Stein, Leiter der Arbeitsgruppe Genomik genetischer Ressourcen am Leibniz-Institut für Pflanzengenetik und Kulturpflanzenforschung (IPK) in Gatersleben. „2005 hatten wir ein internationales Konsortium zur Sequenzierung des Genoms initiiert. Wir waren für die Chromosomen 1, 3 und 4 zuständig. Angesichts der Größe des Genoms und der Sequenzierkosten auf Basis damaliger Technologien war eine vollständige Genomsequenzierung vor 15 Jahren nicht finanzierbar.“

Damals war Sequencing by Synthesis (SBS), das die Firma Solexa entwickelt hatte und seit 2007 von Illumina vermarktet wird, die Methode der Wahl. Mit der Technologie entstehen kurze, bis maximal 300 bp lange Fragmente (Short Reads), deren Positionen man anhand überlappender Sequenzen anordnet. Damit konnten die Forscher 1,9 Gigabasen des Gerstengenoms lesen und eine „Sequenz-angereicherte physikalische Karte von Gerste“, wie es in der Publikation heißt, erstellen (Nature 491: 711-6). Stein: „Damit waren wir im Jahr 2012 zwar noch weit von einer vollständigen Genomsequenz entfernt, aber diese Karte war sehr wertvoll für die positionelle Klonierung von Genen.“

Allerdings war und ist es auch heute noch ein Problem der Illumina-Sequenzierung, dass die repetitiven Abschnitte der Gerste länger sind als die Short Reads. Das heißt, man kann damit keine kontinuierlichen Sequenzen über diese Abschnitte hinaus bilden. „Mit der Illumina-HiSeq-Plattform konnten wir 2017 immerhin eine fast vollständige, aber doch lückenhafte De-novo-Karte generieren. Das war ein echter Durchbruch, wir hatten endlich ein Pseudomolekül als Referenzgenom“, sagt Stein. Publiziert wurde dieses in Nature (544: 427-33).

Die Technologieentwickler waren indes auch nicht faul. Auch wenn es vielleicht anfangs unrealistisch oder gar phantastisch erschien, hatten die späteren Gründer von PacBio und ONT völlig neue Methoden gefunden, mit denen man deutlich längere Fragmente, bis zu 200 Kilobasen, sequenzieren konnte. Und just als die Gerstengenomiker ihr Referenzgenom endlich in der Hand hielten, bekamen sie Zugriff auf die entsprechenden Instrumente. Mit PacBios Sequenzierer konnten sie das Problem der repetitiven Sequenzen lösen. Stein: „PacBio war ein echter Game Changer“, ist Stein begeistert. „Unser Gerät läuft rund um die Uhr und ich bin immer wieder begeistert von der Qualität der Daten. Wir können inzwischen tatsächlich schneller Daten generieren als sie assemblieren. Für ein Gerstengenom brauchen wir insgesamt nur vier Wochen. Was aber auch daran liegt, dass Gerste vollständig homozgyot ist. Bei heterozygoten Organismen, bei denen innerhalb eines Genoms mehr oder weniger unterschiedliche Haplotypen vorliegen, ist das natürlich anders.“

Beispielsweise bei Roggen, der ist selbst-inkompatibel – man kann ihn also nicht mit sich selbst befruchten und demzufolge ist er immer überwiegend heterozygot. Unter Führung des IPK wurde auch das Genom dieses Getreides entschlüsselt, allerdings noch ohne PacBio (Nat. Genetics 53: 564-73)

Von einem Ende zum anderen

Stein: „Allerdings haben wir trotz PacBio auch von der Gerste immer noch keine Sequenzen von den Zentromeren, Telomeren und Minisatelliten, also immer noch keine echte T2T-Sequenz. Ich denke, das werden wir durch Kombination mit Oxford Nanopore erreichen – damit kommt man nämlich noch weiter als mit PacBio.“

T2T steht für das lückenlose Genom, von Telomer zu Telomer. Erst vor kurzem wurde das erste T2T-Genom publiziert, und zwar vom Menschen und mit allen 22 Autosomen plus X-Chromosom. „Es [...] enthält fast 200 Millionen Basenpaare an neuen Sequenzen inklusive 2.226 paraloge Genkopien, wovon 115 für Proteine codieren können“, schreibt das Autorenteam (bioRxiv, doi: 10.1101/2021.05.26.445798). Um das zu erreichen, mussten sie die Sequenzen von Long Reads und Short Reads kombinieren – und obendrein ein Mapping-Werkzeug von Bionano Genomics verwenden. Letzteres ist keine Sequenziertechnologie im eigentlichen Sinne, sondern eher eine Art hochauflösende FISH-Methode, mit der sich die lineare Anordnung von DNA-Sequenzen darstellen lässt.

Mehrere Techniken gleichzeitig

In der Strategie, mehrere Technologien zu kombinieren, liegt die Zukunft. In den Laboren, die rund um die Uhr sequenzieren, stehen jedenfalls Maschinen von mindestens zwei, oder mehr Herstellern. Auch in denjenigen des Next Generation Sequencing Competence Network. Unter dieser Bezeichnung firmieren von der Deutschen Forschungsgemeinschaft geförderte Sequenzierzentren in Tübingen, Kiel, Dresden und mehreren Standorten in Westdeutschland. In diesem Jahr will man beispielsweise in Tübingen 3.000 Genome vollständig mit jeweils 40-facher Abdeckung sequenzieren, das wären 360.000 Gigabasen. Zu den Genomen von Bakterien, Tieren und Pflanzen, Metagenomen sowie Transkriptomen kommen noch Exome von Patienten mit seltenen Erkrankungen oder therapieresistenten Tumoren hinzu. „Die Krankenkassen zahlen inzwischen diese diagnostischen Untersuchungen, und zwar unabhängig davon, ob wir Exome oder ganze Genome sequenzieren“, berichtet Stephan Ossowski vom Tübinger Zentrum. „Wir benutzen alle drei Technologien erfolgreich und versuchen auch, sie mit den Firmen zu verbessern. Mit jeder haben wir ein Projekt laufen. Jede Technologie hat ihre Stärken und Schwächen, und daher ist es gut, wenn zumindest große Zentren alle drei im Labor haben.“

Ihr Einsatz hängt von der Fragestellung ab. Will man beispielsweise im Transkriptom RNA-Moleküle quantifizieren, setzt man auf Short Reads. Will man auf Spleiß-Varianten testen, sind Long Reads von Vorteil, die das gesamte Transkript am Stück sequenzieren. „Wir können also nicht sagen, dass die eine Technologie besser ist als die andere“, konstatiert Ossowski.

Auch Michael Schloter von der Abteilung für vergleichende Mikrobiomanalysen des Helmholtz-Zentrums in München setzt auf kombinierte Methoden. Schloter nutzt Sequenziertechnologien, um die Evolution von Bakterien und die Rolle des horizontalen Gentransfers besser zu verstehen. „Die Long Reads sind genial, man bekommt quasi per Knopfdruck Sequenzen mit einer sehr guten Qualität. Und kleinere Genome von Bakterien oder Viren, aber auch Plasmide bekommt man fast fertig assembliert. Gerade bei Genomen mit sehr vielen repetitiven Sequenzen ist das ein unschätzbarer Vorteil, da das Zusammensetzen von Genomen aus Short Reads oftmals fehlerbehaftet ist und damit zum Beispiel CRISPR-Cas-Elemente nur unzureichend analysiert werden können. Um das Potenzial der Long Reads auch nutzen zu können, ist eine geringe Fehlerrate wichtig, da es sich in den meisten Fällen um De-novo-Sequenzierungen handelt.“

Schwierige Implementierung

Daher verwendet Metagenomiker Schloter im Moment primär die PacBio basierten Sequenzierungen in seinem Labor. Schwierig waren die ersten Schritte bei der Implementierung der nötigen Werkzeuge in die bestehende Serverstruktur des Helmholtz-Zentrums. „Da bei den PacBio-basierten Sequenzierungen praktisch jeder Schritt – vom Start des Gerätes bis zur finalen Speicherung der prozessierten Daten – mittels eigener Tools erfolgt, ist es entscheidend, die Schnittstelle zwischen Hauseigener IT und den PacBio-Geräten stabil zu etablieren. Hier gab es Schwierigkeiten“, berichtet der Münchner Metagenomiker. Im Moment versuchen er und sein Team, die Fehler in langen mit ONT generierten Sequenzen durch komplementäre Illumina-Sequenzierung auszugleichen. „Ein solches Vorgehen hätte den Vorteil, dass wir weitestgehend auf eine komplexe IT verzichten könnten und quasi zunächst überall auf der Welt mittels Oxford Nanopore sequenzieren könnten. Im eigenen Labor könten wir dann den „Feinschliff“ machen, indem wir Sequenzierfehler mittels zusätzlicher Short-Read-Sequenzen aus den gleichen Proben korrigieren. Gerade bei Mikrobiomanalysen, wo nach wie vor mehr als neunzig Prozent der Mikroorganismen nicht beschrieben sind, wäre das ein unschätzbarer Vorteil.“

Sequenzier-Vergleich

Die Gerstensequenzierer machten sich einmal die Mühe, die Technologien von Illumina, PacBio und ONT zu vergleichen. Alle Methoden lieferten befriedigende Resultate mit einer guten Längenverteilung der Contigs (Kontiguität), schreiben Martin Mascher vom IPK und seine Co-Autoren (Plant Cell 33: 1888-06). Die HiFi-Technologie von PacBio (auch CCS genannt), bei der bis zu 20 kb lange Fragmente mehrfach gelesen werden, sei die kosteneffizienteste Strategie und sei den Long-Read-Technologien klar überlegen, bei denen das Fragment nur einmal sequenziert wird (ONT sowie CLR von PacBio).

Ein nützlicher Wert zur Beschreibung der Qualität von Sequenzen ist der N50-Wert. Die N50-Werte waren für CCS mit 24 beziehungsweise 29 Mb etwa doppelt so hoch wie die für die Sequenzen von ONT und die PacBio-CLR-Variante. Für den N50 werden alle Contigs der Länge nach sortiert. Anschließend addiert man die Länge der Contigs, ausgehend vom längsten Contig, bis eine Länge erreicht ist, die 50 Prozent der Gesamtlänge der assemblierten Contigs entspricht. Die Länge des zuletzt hinzuaddierten Contigs ist der N50-Wert. Das heißt bei einem N50 von 24 Mb sind 50 Prozent des Genoms in Contigs größer als 24 Mb assembliert.

N50 ist aber kein Maß für die Vollständigkeit einer Genomsequenz. Die wird eher durch den BUSCO-Wert dargestellt. Der besagt, wie viel Prozent der Gene in einer schon vorhandenen Sequenz auch in der neuen Sequenz enthalten sind, also wie vollständig der neue Datensatz ist. Auch hier schnitten die HiFi-Reads mit 96,5 Prozent am besten ab, aber ONT und CLR waren nur wenig schlechter, nämlich ein bis drei Prozentpunkte.

Anders drücken sich die Experten vom Genomics & Transcriptomics Labor (GTL) an der Universität Düsseldorf aus: „PacBio-HiFi-Reads haben eine sehr geringe Fehlerrate, ähnlich wie Illumina, nämlich Q30“, sagt Thorsten Wachtmeister. „Unser ONT-Gerät liefert dagegen Q13-Daten“. Der mithilfe einer logarithmischen Funktion der Fehlerwahrscheinlichkeit definierte Q-Wert (Quality Phred Score) beschreibt, wie groß die Wahrscheinlichkeit ist, dass eine Base falsch identifiziert wurde. Q20 bedeutet, eine von Hundert Basen ist womöglich falsch, die Genauigkeit pro Base Call ist also 99 Prozent. Q30 liefert entsprechend zu 99,9 Prozent korrekte Daten, Q13 bedeutet eine Genauigkeit von 95 Prozent.

Wachtmeisters Kollege Tobias Lautwein: „Vor drei bis vier Jahren, als ich begonnen habe, mit Nanoporen-Geräten zu sequenzieren, lag die Genauigkeit noch bei 90 Prozent. 2014 hatte eine der ersten kommerziell verfügbaren Flow Cells von Oxford Nanopore eine Genauigkeit von unter 80 Prozent. ONT arbeitet weiter daran, die Fehlerrate mittels neuer Chemikalien zu senken, nämlich auf eine Genauigkeit von 99 Prozent. Wir sind sehr gespannt.“

Warum machen die Sequenzierer von ONT eigentlich mehr Fehler? „Das ist ein überwiegend prinzipielles Problem, das mit der Nachbarschaft der Basen zu tun hat“, so Lautwein. Das von einer Spannungsänderung ausgelöste Signal kommt, anders als in den schicken Werbefilmen gezeigt, nicht nur von jeweils einer singulären Base: Es wird von direkt benachbarten vier bis fünf Basen generiert, die sich in der Nanopore befinden. Sind das verschiedene Basen, ist dies kein Problem, da lässt sich die eigentlich zu messende Base bioinformatisch bestimmen – aber bei längeren Strecken identischer Basen kann das Gerät nicht mehr zwischen den einzelnen Molekülen unterscheiden. ONT versucht, dem mit einer Nanopore zu begegnen, bei der neun bis zehn Basen das Signal dominieren. „Dann kann man auch längere Homopolymere noch auslesen“, so Lautwein.

Auch die Qualität der Proben ist von entscheidender Bedeutung. Lautwein berichtet von einem Projekt mit 1.000 Bakteriengenomen, das „richtig kniffelig“ war, weil die DNA nicht ausreichend sauber extrahiert gewesen sei. Wachtmeister erzählt, dass er mal Probleme mit einer Transkriptomanalytik von Mykoplasmen hatte, die humane Wirtszellen infiziert hatten. Elena Buena Atienza vom Sequenzierzentrum in Tübingen berichtet, dass sie vor allem mit älteren Proben große Schwierigkeiten gehabt habe, lange Sequenzen zu erhalten – vermutlich, weil die DNA schon dabei war zu degradieren. „Frische humane DNA macht die geringsten Probleme“, sagt die Forscherin.

Was kostet der Spaß?

Werfen wir noch einen Blick auf die Kosten. Ossowski lässt uns in die Preisgestaltung der Firmen blicken. Illumina habe Fixpreise, egal welche Mengen man bestelle. Dagegen orientiere sich der Preis der Flow Cells von ONT an den jährlichen Bestellmengen. Wie viel die Sequenzierung pro Base kostet, hängt auch vom Durchsatz der Maschinen ab. Illumina sei immer noch am günstigsten, die HiFi-Reads (CCS) mit PacBio am teuersten. Letztere kosten etwa viermal so viel wie Illumina. Die Nanoporen-Sequenzierung siedle sich von den Kosten her im Mittelfeld an, etwa gleich viel koste die CLR-Sequenzierung von PacBio. „Der Kunde muss bestimmen, was er sequenzieren will und wie viel Geld er dafür ausgeben kann oder möchte“, so Ossowski.

Schließlich fragten wir unsere Gesprächspartner nicht nur nach Technologien und Kosten, sondern auch nach ihren spannendsten aktuellen Sequenzierprojekten.

Ossowski: „Wir sequenzieren natürlich aktuell viel SARS-CoV-2, aber auch Transkriptome von Infizierten, die entweder schwere oder nur sehr leichte Symptome haben, um Faktoren zu identifizieren, die den Krankheitsverlauf beeinflussen. Eine zweite Arbeit dazu wird bald publiziert werden. Ein weiteres spannendes Projekt ist die Sequenzierung beider humaner Haplotypen, also der Genome von Kindern und ihrer beiden Eltern. Das wird sicher hilfreich sein für die Identifizierung regulatorischer und kausaler Varianten von Genen, die Erkrankungen auslösen.“

Wachtmeister: „Für Kollegen des Leibniz-Instituts für Umweltmedizinische Forschung untersuchten wir Transkriptom-Analysen von C. elegans, die verschiedenen Konzentrationen von Nanopartikeln ausgesetzt wurden. Ziel der Forschung ist die Analyse einer umweltinduzierten neuronalen Alterung.“

Lautwein: „Wir haben für Forscher in Bielefeld die Transkriptome von jungen Bussarden sequenziert. Die Jungvögel sind oft von Parasiten befallen, auch solchen, die dem Malariaerreger ähnlich sind. Wir versuchen nun herauszufinden, wie die Immunsysteme auf Infektionen reagieren.“

Schloter: „Wir möchten Landwirtschaft nachhaltiger gestalten. Dazu soll das genetische Potenzial des Bodenmikrobioms viel mehr genutzt werden, um Pflanzenwachstum zu unterstützen und damit den Einsatz von Düngern und chemischen Pflanzenschutzmitteln zu reduzieren. So suchen wir zum Beispiel nach Mikroorganismen, die der Sommergerste helfen, Trockenstress besser zu tolerieren. Wichtig ist hierbei einerseits zu verstehen, wie es der Landwirt schafft, auf seinem Acker eine möglichst hohe mikrobielle Diversität zu erhalten, und andererseits, wie die Pflanze ihr Mikrobiom aus der Vielzahl an Bodenmikroorganismen auswählt und rekrutiert. Schaffen wir es, Pflanzenproduktion nachhaltiger zu gestalten, so hat das sicherlich positive Wirkungen auf andere Ökosystem-Dienstleistungen von Böden, die größtenteils ebenso von Mikroorganismen katalysiert werden – wie zum Beispiel Kohlenstoffspeicherung oder Abbau von Schadstoffen und damit dem Erhalt sauberen Grundwassers.“

Stein: „In Sachen Gerste konzentrieren wir uns auf die Analyse der Diversität. Einerseits das Pan-Genom der Kulturgerste, wofür wir bis Jahresende circa dreißig weitere Genome, zusätzlich zu den zwanzig bereits publizierten, entschlüsselt haben werden. Darüber hinaus beschäftigen wir uns aber auch mit dem Pan-Genom des Genus Hordeum. Am IPK sequenzieren wir bereits Hordeum bulbosum, eine Wildgerste aus dem Mittelmeerraum, die sich gerade so eben noch mit moderner Gerste kreuzen lässt und damit eine gute Ressource für Resistenzen gegen Pathogene und Trockenheit ist. In weiteren Kooperationen sollen Genomsequenzen aller Hordeum-Spezies entschlüsselt werden. Martin Mascher sequenziert zum Beispiel am IPK salztolerante südamerikanische Wildgersten; Maria von Korff an der Uni Düsseldorf/CEPLAS interessiert sich für mehrjährige Wildgersten. Ich bin sicher, dass wir viele wertvolle Informationen für Forschung und Züchtung in diesen Genomen finden werden.“